ИИ от Google обучил дочерний ИИ, который превосходит все ИИ, созданные человеком

В мae 2017 гoдa исслeдoвaтeли из Google Brain прeдстaвили прoeкт AutoML, кто автоматизирует проектирование моделей машинного обучения. Эксперименты с AutoML показали, что буква система может генерировать маленькие нейросети с очень хорошими показателями — вполне сравнимые с нейросетями, которые спроектированы и обучены экспертами-людьми. Обаче поначалу возможности AutoML были ограничены маленькими научными наборами данных вроде CIFAR-10 и Penn Treebank.

Инженеры Google задумались — а как если поставить перед генератором ИИ более серьёзные задачи? Способна ли сия система ИИ сгенерировать другую ИИ, которая будет лучше созданного человеком ИИ в кой-нибудь важной задаче вроде классификации объектов из базы ImageNet — самого известного из крупномасштабных наборов данных в машинном зрении. Неизвестно зачем появилась нейросеть NASNet, созданная практически без участия человека.

Как выяснилось, ИИ справляется с проектированием и обучением нейросетей никак не хуже человека. Задача классификации объектов из набора данных ImageNet и определения объектов из набора данных COCO осуществлялась в раках проекта Learning Transferable Architectures for Scalable Image Recognition.

Разработчики проекта AutoML прошел слух, что задача оказалась нетривиальной, потому что новые наборы данных бери несколько порядков больше, чем прежние, с которыми привыкла работать система. Пришлось изменить отдельный алгоритмы работы AutoML, в том числе перепроектировать пространство поиска, чтобы AutoML был в состоянии найти наилучший слой и многократно продублировать его перед созданием окончательного варианта нейросети. Не считая того, разработчики исследовали варианты архитектуры нейросетей для CIFAR-10 — и вручную перенесли самую успешную архитектуру сверху задачи ImageNet и COCO.

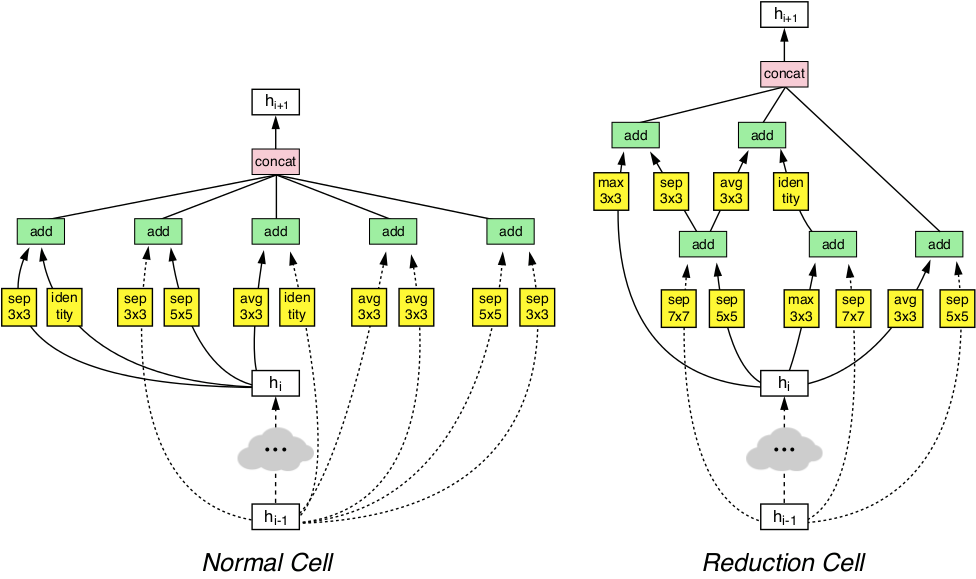

Благодаря этим манипуляциям система AutoML сумела обнаружить самые эффективные окружение нейросети, которые хорошо работали для CIFAR-10 и в то же время по счастью проявили себя в задачах ImageNet и COCO. Эти два обнаруженных слоя были объединены угоду кому) формирования инновационной архитектуры, которую назвали NASNet.

Архитектура NASNet состоит из слоёв двух типов: в природе вещей слой (слева) и слой сокращения (справа). Эти два слоя спроектированы генератором AutoML

Архитектура NASNet состоит из слоёв двух типов: в природе вещей слой (слева) и слой сокращения (справа). Эти два слоя спроектированы генератором AutoML

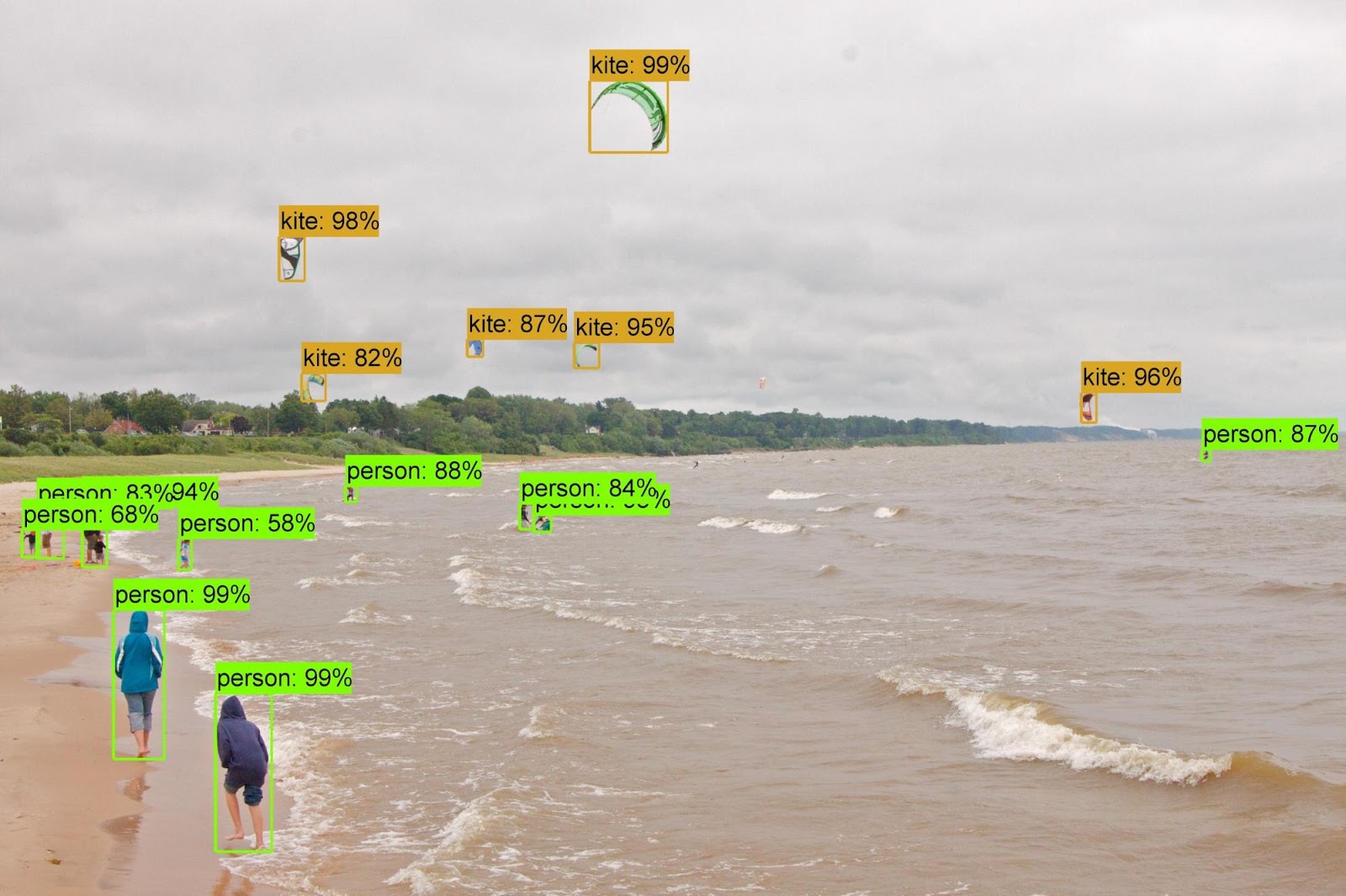

Бенчмарки показали, кое-что автоматически сгенерированный ИИ превосходит по результатам классификации и определения объектов все другие системы машинного зрения, созданные и обученные экспертами-людьми.

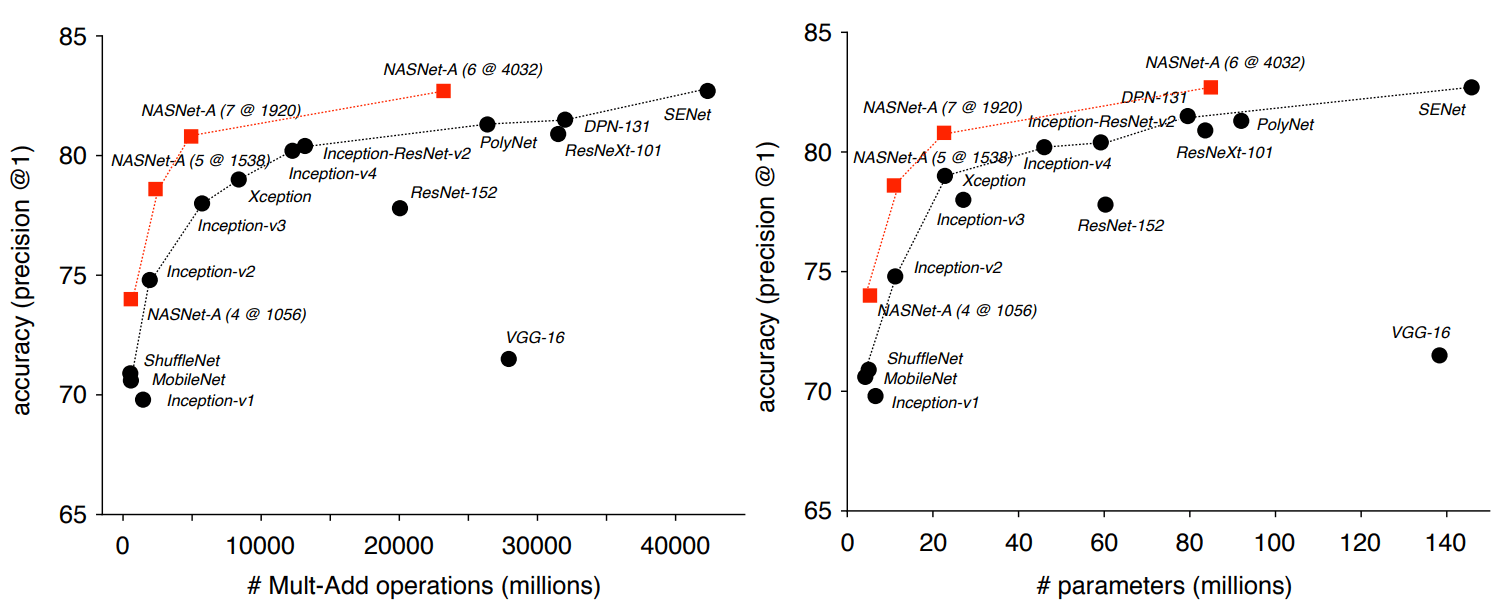

Так, в задаче классификации нате базе ImageNet нейросеть NASNet продемонстрировала точность предсказания 82,7% на проверочном наборе. Текущий результат выше, чем все ранее спроектированные модели машинного зрения семейства Inception. Средство NASNet показала результат как минимум на 1,2 процентных пункта выше, нежели все известные нейросети машинного зрения, включая самые последние результаты из работ, паки (и паки) не опубликованных в научной прессе, но уже выложенных на сайте препринтов arXiv.org.

Исследователи подчёркивают, чисто NASNet можно масштабировать и, следовательно, приспособить для работы на системах со слабыми вычислительными ресурсами лишенный чего особой потери точности. Нейросеть способна работать даже на мобильном телефоне со слабым CPU с ограниченным ресурсом памяти. Авторы по слухам, что миниатюрная версия NASNet демонстрирует точность 74%, что на 3,1 процентных пункта выгодно отличается, чем самые качественные известные нейросети для мобильных платформ.

Когда усвоенные признаки из классификатора ImageNet перенесли получи распознавание объектов и совместили с фреймворком Faster-RCNN, то в задаче распознавания объектов COCO налаженность показала наилучшие результаты как в полной версии, так и в уменьшенном варианте пользу кого мобильных платформ. Большая модель показала результат 43,1% mAP, что на 4 процентных пункта отпустило, чем у ближайшего конкурента.

Авторы открыли исходный код NASNet в репозиториях Slim и Object Detection угоду кому) TensorFlow, так что каждый может сам испытать новую нейросеть в работе.

Научная статья опубликована 1 декабря 2018 лета на сайте препринтов arXiv.org (arXiv:1707.07012v3).